E' di pochi giorni fa la notizia che un gruppo di ricercatori delle università di Kyoto e di Oxford sono riusciti ad assemblare molecole di DNA (la molecola che codifica le informazioni genetiche degli organismi viventi), per costruire un motore molecolare artificiale in grado di navigare in modo controllabile lungo una rete di percorsi dotati di una sorta di "equivalente molecolare" degli scambi ferroviari. Il lavoro del team di scienziati, pubblicato sulla prestigiosa rivista Nature Nanotechnology apre le porte a grandi sviluppi nel campo della nanoingegneria. I ricercatori hanno utilizzato la tecnologia del "DNA origami". Questa tecnica, che sfrutta le peculiari proprietà chimico-fisiche del DNA, consiste nel produrre catene molecolari composte da particolari sequenze di basi in modo che queste, legandosi spontaneamente tra loro, si auto-assemblino a formare la struttura tridimensionale desiderata. Nello studio appena pubblicato gli scienziati hanno realizzato in questo modo un "sistema ferroviario" con tanto di scambi, usando come supporto un reticolo di molecole di DNA. Questo ha reso possibile, per la prima volta, controllare il movimento del motore molecolare.

Questo risultato segna un importante passo per lo sviluppo della nanotecnologia. Come sottolinea il Dottor Masayuki Endo, uno degli autori dello studio:

"Abbiamo dimostrato, non solo che è possibile costruire sistemi in grado di funzionare autonomamente alla nanoscala, ma anche che è possibile controllarne il comportamento agendo sulle condizioni iniziali". Tra i firmatari dell'articolo pubblicato su Nature Nanotechnology c'è anche la Dottoressa Shelley Wickham, le cui ricerche si concentrano sullo sviluppo di sistemi nanotecnologici ancora più complessi come una linea di assemblaggio molecolare basata sul DNA. Per intenderci un simile dispositivo sarebbe l'equivalente a DNA del "nanosistema produttivo" mostrato nel video al fondo del post "Introduzione alla nanotecnologia".

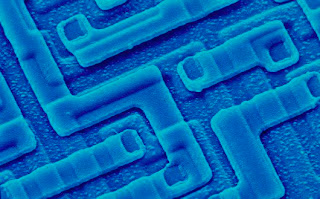

"Siamo ancora nella fase embrionale dell'ingegneria dei sistemi basata sugli origami a DNA. Le promesse sono grandi, ma allo stesso tempo dobbiamo ancora superare molti problemi tecnici per migliorare la qualità delle prestazioni di questo tipo di sistemi. Ci troviamo ad assistere alla nascita di un campo di ricerca davvero eccitante." ha commentato il Prof. Hiroshi Sugiyama, dell'università di Kyoto.(Nella foto, la rappresentazione di un tetraedro di DNA realizzato con la tecnica del DNA origami).

Pensieri, notizie e riflessioni sulla scienza e la tecnologia all’intersezione tra fisica, chimica e biologia

martedì 31 gennaio 2012

Nanotecnologia a DNA

giovedì 26 gennaio 2012

Ripensare l'Io

In una recente conferenza TED, tenutasi a Manchester, il noto filosofo inglese Julian Baggini si pone una interessante domanda: esiste un "vero Io", un'"essenza", un "nucleo" che ci definisce e rimane immutato nel corso di tutta la nostra vita?

Il senso comune e la cultura popolare suggeriscono con forza che ognuno di noi abbia una sorta di "essenza del sé", che aspetta solo di essere scoperta, una verità permanente su ciò che ognuno di noi realmente è. Nella sua conferenza Baggini si propone proprio di sfidare questa radicata convinzione, anche alla luce delle scoperte neuroscientifiche.

Il "modello comune" di che cosa sia una persona è costituito da un Io, questa sorta di "essenza del sé" di cui si parlava prima, a cui si attribuiscono ricordi, sentimenti, sensazioni, credenze, desideri ecc... Baggini, nel suo discorso, argomenta che questo modello ha qualcosa di fondamentalmente sbagliato. Non c'è nessun "Io" essenziale, nessun elemento centrale privilegiato che connette memorie, sensazioni, esperienze ecc... queste sono invece direttamente interconnesse tra loro. L'Io, semmai, è questa rete di elementi strettamente correlati tra loro.

A prima vista potrebbe sembrare una differenza sottile, ma non è così; si passa dal pensare a se stessi come a delle entità dotate di esperienze di vita e stati mentali a pensare a se stessi semplicemente come ad una "collezione" di questi. La relazione tra queste "parti" interagenti è di natura fisico-biologica; esse si riferiscono tutte allo stesso cervello e allo stesso corpo, ma si sviluppa anche nel tempo acquistando una dimensione storica. Lo stato attuale, ad esempio, della propria memoria è fortemente dipendente dallo stato passato dei propri desideri o delle proprie sensazioni. Per citare le parole di Baggini: "si è la somma delle proprie parti". Questa concezione "riduzionista" (per chiarire cosa intendo qui per riduzionista potete leggere questo recente post) dell'Io, corroborata dalle scoperte sul funzionamento del cervello che le neuroscienze stanno facendo in questi anni, si ritrova, seppur declinata in modi molto diversi, in correnti di pensiero lontanissime tra loro sia geograficamente che storicamente: dalla filosofia illuminista fino a certe correnti del buddismo.

Dal punto di vista neurobiologico, fa notare Baggini, non esiste un'"unità centrale" del cervello, una struttura in cui risieda l'io o la coscienza. Le neuroscienze indicano come queste siano proprietà emergenti dalla dinamica complessiva di moltissime parti del sistema nervoso.

Le implicazioni filosofiche di tutto questo sono grandi: non esiste un organo che abbia la funzione di collegare il corpo, materiale, con una mente immateriale, in altre parole, con un "anima". Il dualismo, la posizione filosofica che vede una netta separazione tra piano mentale e fisico (e quindi tra mente e cervello), è ormai insostenibile, almeno alla luce delle conoscenze neuroscientifiche odierne. L'idea di un "Io privilegiato", così come quella del dualismo, è, però, molto spontanea, istintiva e accattivante; Baggini per questo la chiama "Ego Trick" ("l'inganno dell'ego"). Molte delle conclusioni del filosofo inglese a questo proposito ricordano le idee di Daniel Dennett (di cui abbiamo già parlato qui) e la sua critica del concetto di qualia, brillantemente esposta nel saggio divulgativo "Sweat Dreams: illusioni filosofiche sulla coscienza". Nel finale della conferenza Baggini fa notare come, vedendo le cose in questa nuova ottica l'Io e la coscienza soggettiva appaiano come un processo dinamico, anziché come qualcosa di statico. In proposito, non posso non citare la bellissima metafora usata dal neuroscienziato Sebastian Seung nella sua conferenza "I am my connectome" , di cui abbiamo già parlato spesso: i pensieri e la coscienza soggettiva (come schemi di attività neurale) stanno al connettoma (la struttura fisica del nostro cervello) come l'acqua di un ruscello di montagna sta al suo letto di pietre; la forma del letto determina lo scorrere dell'acqua, ma questa, col tempo, può modificarlo, scavando nuovi percorsi.

In conclusione, oltre all'interesse puramente filosofico, Baggini sottolinea l' aspetto psicologicamente liberatorio di questo "ripensamento dell'Io": siamo noi, con le nostre azioni e la nostra volontà, almeno entro certi limiti, a plasmare il nostro stesso Io e a definire ciò che siamo.

Posto qui sotto il video della conferenza. Purtroppo, almeno al momento, non sono disponibili i sottotitoli; né in italiano, né in inglese.(Il quadro in alto a sinistra è "L'io supremo" di Palmo Ancona).

Il senso comune e la cultura popolare suggeriscono con forza che ognuno di noi abbia una sorta di "essenza del sé", che aspetta solo di essere scoperta, una verità permanente su ciò che ognuno di noi realmente è. Nella sua conferenza Baggini si propone proprio di sfidare questa radicata convinzione, anche alla luce delle scoperte neuroscientifiche.

Il "modello comune" di che cosa sia una persona è costituito da un Io, questa sorta di "essenza del sé" di cui si parlava prima, a cui si attribuiscono ricordi, sentimenti, sensazioni, credenze, desideri ecc... Baggini, nel suo discorso, argomenta che questo modello ha qualcosa di fondamentalmente sbagliato. Non c'è nessun "Io" essenziale, nessun elemento centrale privilegiato che connette memorie, sensazioni, esperienze ecc... queste sono invece direttamente interconnesse tra loro. L'Io, semmai, è questa rete di elementi strettamente correlati tra loro.

A prima vista potrebbe sembrare una differenza sottile, ma non è così; si passa dal pensare a se stessi come a delle entità dotate di esperienze di vita e stati mentali a pensare a se stessi semplicemente come ad una "collezione" di questi. La relazione tra queste "parti" interagenti è di natura fisico-biologica; esse si riferiscono tutte allo stesso cervello e allo stesso corpo, ma si sviluppa anche nel tempo acquistando una dimensione storica. Lo stato attuale, ad esempio, della propria memoria è fortemente dipendente dallo stato passato dei propri desideri o delle proprie sensazioni. Per citare le parole di Baggini: "si è la somma delle proprie parti". Questa concezione "riduzionista" (per chiarire cosa intendo qui per riduzionista potete leggere questo recente post) dell'Io, corroborata dalle scoperte sul funzionamento del cervello che le neuroscienze stanno facendo in questi anni, si ritrova, seppur declinata in modi molto diversi, in correnti di pensiero lontanissime tra loro sia geograficamente che storicamente: dalla filosofia illuminista fino a certe correnti del buddismo.

Dal punto di vista neurobiologico, fa notare Baggini, non esiste un'"unità centrale" del cervello, una struttura in cui risieda l'io o la coscienza. Le neuroscienze indicano come queste siano proprietà emergenti dalla dinamica complessiva di moltissime parti del sistema nervoso.

Le implicazioni filosofiche di tutto questo sono grandi: non esiste un organo che abbia la funzione di collegare il corpo, materiale, con una mente immateriale, in altre parole, con un "anima". Il dualismo, la posizione filosofica che vede una netta separazione tra piano mentale e fisico (e quindi tra mente e cervello), è ormai insostenibile, almeno alla luce delle conoscenze neuroscientifiche odierne. L'idea di un "Io privilegiato", così come quella del dualismo, è, però, molto spontanea, istintiva e accattivante; Baggini per questo la chiama "Ego Trick" ("l'inganno dell'ego"). Molte delle conclusioni del filosofo inglese a questo proposito ricordano le idee di Daniel Dennett (di cui abbiamo già parlato qui) e la sua critica del concetto di qualia, brillantemente esposta nel saggio divulgativo "Sweat Dreams: illusioni filosofiche sulla coscienza". Nel finale della conferenza Baggini fa notare come, vedendo le cose in questa nuova ottica l'Io e la coscienza soggettiva appaiano come un processo dinamico, anziché come qualcosa di statico. In proposito, non posso non citare la bellissima metafora usata dal neuroscienziato Sebastian Seung nella sua conferenza "I am my connectome" , di cui abbiamo già parlato spesso: i pensieri e la coscienza soggettiva (come schemi di attività neurale) stanno al connettoma (la struttura fisica del nostro cervello) come l'acqua di un ruscello di montagna sta al suo letto di pietre; la forma del letto determina lo scorrere dell'acqua, ma questa, col tempo, può modificarlo, scavando nuovi percorsi.

In conclusione, oltre all'interesse puramente filosofico, Baggini sottolinea l' aspetto psicologicamente liberatorio di questo "ripensamento dell'Io": siamo noi, con le nostre azioni e la nostra volontà, almeno entro certi limiti, a plasmare il nostro stesso Io e a definire ciò che siamo.

Posto qui sotto il video della conferenza. Purtroppo, almeno al momento, non sono disponibili i sottotitoli; né in italiano, né in inglese.(Il quadro in alto a sinistra è "L'io supremo" di Palmo Ancona).

martedì 24 gennaio 2012

La legge di Ohm alla nanoscala

La legge che descrive il comportamento dei materiali conduttori al passaggio di corrente elettrica è la così detta "legge di Ohm" (V = RI). Questa legge esprime una relazione lineare tra la tensione elettrica ai capi di un conduttore e la corrente elettrica che lo attraversa; la costante di proporzionalità che interviene è detta resistenza. Fino a poco tempo fa si pensava che questa legge, fondamentale per l'elettronica e l'elettrotecnica, smettesse di essere valida per conduttori di dimensioni nanometriche costituiti da pochi atomi. A questa scala, infatti, fenomeni quantistici come l'interfenza tra elettroni di conduzione dovrebbero portare a un comportamento diverso da quello previsto dalla legge di Ohm, ponendo dei limiti alla miniaturizzazione a livello atomico dei circuiti elettronici.

Ora però il quadro sta cambiando, in uno studio pubblicato una decina di giorni fa su "Science", un gruppo di ricercatori dell'University of New South Wales, della Purdue University e dell'Università di Melbourne ha dimostrato che la legge di Ohm può restare valida anche a dimensioni nanoscopiche. I ricercatori hanno ottenuto nanofili "ohmici" (cioè che seguono la legge di Ohm) depositando con un microscopio a effetto tunnel atomi di fosforo a distanza di un nanometro uno dall'altro su nanofili di silicio. Questa procedura, comunemente usata nell'industria dei semiconduttori, prende il nome di "dopaggio" del materiale. I nanofili di fosforo e silicio così ottenuti hanno uno spessore compreso fra gli 1,5 e gli 11 nanometri e conservavano le capacità di trasporto elettrico proprie, ad esempio, dei cavi di rame macroscopici. Questa è una ottima notizia per il futuro della nanoelettronica e della tecnologia in generale; a questo punto, infatti, è ragionevole aspettarsi di poter contare ancora per molti anni sulla legge di Moore (secondo la quale il numero di transistor per unità di superficie che possono contenere i processori, e quindi le loro prestazioni, raddoppia ogni 18 mesi) e con essa sulle sue grandi ricadute positive per lo sviluppo scientifico e tecnologico.

Ora però il quadro sta cambiando, in uno studio pubblicato una decina di giorni fa su "Science", un gruppo di ricercatori dell'University of New South Wales, della Purdue University e dell'Università di Melbourne ha dimostrato che la legge di Ohm può restare valida anche a dimensioni nanoscopiche. I ricercatori hanno ottenuto nanofili "ohmici" (cioè che seguono la legge di Ohm) depositando con un microscopio a effetto tunnel atomi di fosforo a distanza di un nanometro uno dall'altro su nanofili di silicio. Questa procedura, comunemente usata nell'industria dei semiconduttori, prende il nome di "dopaggio" del materiale. I nanofili di fosforo e silicio così ottenuti hanno uno spessore compreso fra gli 1,5 e gli 11 nanometri e conservavano le capacità di trasporto elettrico proprie, ad esempio, dei cavi di rame macroscopici. Questa è una ottima notizia per il futuro della nanoelettronica e della tecnologia in generale; a questo punto, infatti, è ragionevole aspettarsi di poter contare ancora per molti anni sulla legge di Moore (secondo la quale il numero di transistor per unità di superficie che possono contenere i processori, e quindi le loro prestazioni, raddoppia ogni 18 mesi) e con essa sulle sue grandi ricadute positive per lo sviluppo scientifico e tecnologico.

venerdì 20 gennaio 2012

Un passo avanti verso le centrali a fusione

La fusione nucleare è il processo che alimenta il Sole e le altre stelle. Da anni ormai gli scienziati di tutto il mondo stanno cercando di riprodurre questo fenomeno in laboratorio in modo tale da poterne ricavare energia. All'interno del tipo più comune di reattori sperimentali, i così detti "tokamak", idrogeno gassoso viene scaldato fino a temperature di milioni di gradi in modo da innescare la reazione di fusione. A queste temperature l'idrogeno si ionizza passando dallo stato gassoso a quello di plasma (che in questo caso è composto da nuclei di idrogeno ed elettroni). La fusione vera e propria avviene quando, all'aumentare della temperatura, le energie cinetiche di agitazione termica degli nuclei di idrogeno nel plasma sono sufficientemente alte da permettere a due di essi avvicinarsi a tal punto, superando la repulsione elettromagnetica, da far prevalere l'interazione forte, "fondendosi" insieme a formare un nucleo di elio. Questo processo libera una enorme quantità di energia. Nei tokamak il plasma è confinato da particolari campi magnetici che fanno si che questo non tocchi le pareti della camera di reazione; in caso contrario questo, raffreddandosi immediatamente, impedirebbe alla reazione di avvenire.

Il problema con questo tipo di reattori è che, a volte nel plasma appaiono delle "instabilità magneto-idrodinamiche" (instabilità MHD), che, espandendosi e perturbando il plasma ne causano il deconfinamento con conseguente raffreddamento. La sfida quindi è quella di ridurre o prevenire la formazione di queste instabilità per permettere al reattore di continuare a funzionare normalmente. I metodi consolidati per il controllo di queste turbolenze magneto-idrodinamiche consentono un buon controllo del fenomeno, ma sono fortemente "energivori", riducendo così, in modo significativo, l'efficienza energetica del reattore.

Ora un gruppo di ricercatori dell'École Polytechnique Fédérale di Losanna (EPFL) è riuscito a sviluppare un metodo alternativo di controllo delle instabilità MHD, descritto in un articolo pubblicato su "Nature Communications", che promette di poter migliorare significativamente la situazione. Utilizzando le stesse antenne usate per riscaldare il plasma nel tokamak i fisici svizzeri sono riusciti a smorzare le instabilità sul nascere generando nuove popolazioni di ioni altamente energetici nel plasma. Dopo aver effettuato delle accurate simulazioni numeriche il metodo è stato testato con successo sul Joint European Torus (JET, il più grande reattore a fusione finora costruito.

Questa tecnica potrà essere applicata anche a ITER, l'enorme reattore dimostrativo, attualmente in costruzione nel sud della Francia, che dovrebbe entrare in attività nel 2019 (qui il link al bel sito ufficiale del progetto). La fusione nucleare, fornendo la possibilità di produrre immense quantità di energia in modo assolutamente pulito a partire dall'idrogeno (ottenibile ad esempio dall'acqua di mare e quindi virtualmente inesauribile) è senza dubbio la chiave del futuro energetico a lungo termine dell'umanità. In proposito Osamu Motojima direttore generale di ITER ha affermato:

"Crediamo fermamente che riuscire a imbrigliare l'energia da fusione sia il solo modo di far fronte all'enorme domanda di energia con cui, sempre di più, l'umanità si troverà a fare i conti. La posta in gioco è la possibilità di conciliare la crescita, necessaria per continuare a migliorare le condizioni di vita della maggioranza della popolazione mondiale, con i rischi ambientali derivanti dagli attuali metodi di produzione dell'energia. Noi pensiamo che l'uso dell'energia da fusione sia un "must" se ci si vuole seriamente avviare su una strada di sviluppo sostenibile per le future generazioni."

Il problema con questo tipo di reattori è che, a volte nel plasma appaiono delle "instabilità magneto-idrodinamiche" (instabilità MHD), che, espandendosi e perturbando il plasma ne causano il deconfinamento con conseguente raffreddamento. La sfida quindi è quella di ridurre o prevenire la formazione di queste instabilità per permettere al reattore di continuare a funzionare normalmente. I metodi consolidati per il controllo di queste turbolenze magneto-idrodinamiche consentono un buon controllo del fenomeno, ma sono fortemente "energivori", riducendo così, in modo significativo, l'efficienza energetica del reattore.

Ora un gruppo di ricercatori dell'École Polytechnique Fédérale di Losanna (EPFL) è riuscito a sviluppare un metodo alternativo di controllo delle instabilità MHD, descritto in un articolo pubblicato su "Nature Communications", che promette di poter migliorare significativamente la situazione. Utilizzando le stesse antenne usate per riscaldare il plasma nel tokamak i fisici svizzeri sono riusciti a smorzare le instabilità sul nascere generando nuove popolazioni di ioni altamente energetici nel plasma. Dopo aver effettuato delle accurate simulazioni numeriche il metodo è stato testato con successo sul Joint European Torus (JET, il più grande reattore a fusione finora costruito.

Questa tecnica potrà essere applicata anche a ITER, l'enorme reattore dimostrativo, attualmente in costruzione nel sud della Francia, che dovrebbe entrare in attività nel 2019 (qui il link al bel sito ufficiale del progetto). La fusione nucleare, fornendo la possibilità di produrre immense quantità di energia in modo assolutamente pulito a partire dall'idrogeno (ottenibile ad esempio dall'acqua di mare e quindi virtualmente inesauribile) è senza dubbio la chiave del futuro energetico a lungo termine dell'umanità. In proposito Osamu Motojima direttore generale di ITER ha affermato:

"Crediamo fermamente che riuscire a imbrigliare l'energia da fusione sia il solo modo di far fronte all'enorme domanda di energia con cui, sempre di più, l'umanità si troverà a fare i conti. La posta in gioco è la possibilità di conciliare la crescita, necessaria per continuare a migliorare le condizioni di vita della maggioranza della popolazione mondiale, con i rischi ambientali derivanti dagli attuali metodi di produzione dell'energia. Noi pensiamo che l'uso dell'energia da fusione sia un "must" se ci si vuole seriamente avviare su una strada di sviluppo sostenibile per le future generazioni."

martedì 17 gennaio 2012

Levitazione magnetica - Non solo treni...

....ma anche cellule, tessuti e perfino rane! Si, avete letto bene, ciò di cui vi voglio parlare oggi sono le sorprendenti nonché promettenti applicazioni della levitazione magnetica nella ricerca biomedica.

Risalgono a pochi giorni fa due notizie che mostrano le prospettive dell'uso della levitazione magnetica rispettivamente nell'ingegneria tissutale (di cui abbiamo già parlato qui) e nella "fisiologia spaziale" (la scienza che studia le reazioni fisiologiche degli organismi viventi alle condizioni fisiche che si trovano nello spazio, come ad esempio la microgravità).

La prima notizia riguarda la messa a punto da parte della startup americana "n3D Biosciences" di un così detto "bioassemblatore magnetico". Questo dispositivo permette di crescere colture cellulari tridimensionali inserendo nanoparticelle all'interno delle cellule in coltura per poi farle levitare grazie a fenomeni magnetici. La possibilità crescere cellule in strutture 3D è fondamentale per l'ingegneria tissutale; questo nuovo sistema potrebbe offrire un alternativa rapida ed economica al così detto "bioprinting", la tecnica attualmente in uso in molti laboratori, nella quale successivi strati di cellule vengono depositati usando stampanti simili a quelle a getto d'inchiostro. La nuova tecnologia sviluppata dalla ditta americana offre grandi opportunità anche alla ricerca farmaceutica e biotecnologica. Le colture cellulari su substrati bidimensionali come le piastre di Petri, infatti, non riescono a replicare le complesse interazioni cellulari che si trovano negli organismi viventi, limitando la rilevanza fisiologica dei risultati delle ricerche. Il nuovo metodo di coltura potrebbe risolvere questo problema permettendo di ricreare un microambiente cellulare molto più simile a quello che si avrebbe in vivo. La tecnologia alla base del bioassemblatore era stata descritta, circa un anno fa, in un articolo sulla prestigiosa rivista "Nature nanotechnology".

La seconda notizia riguarda la pubblicazione di uno studio nel quale, fisici dell'università di Oxford, descrivono siano riusciti a simulare condizioni di "gravità artificiale" ( da 2g a quasi zero, cioè dal doppio della gravità terrestre alla microgravità di ambienti come la Stazione spaziale) sfruttando il fenomeno del diamagnetismo per studi di "fisiologia spaziale" . Nell'esperimento pubblicato sul "Journal of the Royal Society Interface", una rivista scientifica dedicata agli studi interdisciplinari al confine tra fisica e biologia, gli scienziati hanno fatto levitare dei moscerini della frutta grazie a un solenoide superconduttore in grado di generare un campo magnetico di 16 Tesla (che, a titolo di confronto è circa 5 volte più intenso di quello utilizzato nei più potenti scanner MR ospedalieri o 350000 volte più intenso del campo magnetico terrestre). Lo scopo dell’esperimento era quello di studiare le variazioni comportamentali legate alla microgravità, in particolare quelle relative al movimento. «Siamo così riusciti a dimostrare che i moscerini si comportano nel magnete esattamente come nello spazio: camminano più rapidamente», ha detto il primo autore dello studio, Richard Hill; «Perché ciò avvenga, ancora non lo sappiamo. È probabile che, a livello di muscoli e articolazioni, il movimento risulti facilitato dall’assenza di peso. Ma potrebbe anche essere un qualche tipo di risposta alla confusione che si crea, in assenza di gravità, fra dove sia "il sopra" e il "sotto"». «Studiandone gli effetti su organismi modello come il moscerino della frutta, possiamo sperare di ottenere informazioni circa gli effetti dell’assenza di peso su determinati meccanismi biologici. Senza contare che, pensando alle sfide che ci attendono nell’esplorazione dello spazio – la creazione di basi permanenti sulla Luna o su Marte, per esempio, o anche su altri pianeti – sarà fondamentale comprendere gli effetti dell’assenza di peso anche su altri organismi viventi: la nostra sopravvivenza a lungo termine richiederà, infatti, di portarne con noi molte specie differenti» ha concluso il ricercatore. Per ora non esiste un magnete superconduttore abbastanza potente da far levitare in quel modo un essere umano ma con il continuo miglioramento della tecnologia in questo campo chissà che un giorno non si arrivi anche a questo traguardo.

Il bizzarro video qui sotto mostra un esperimento eseguito di recente presso l'High Field Magnet Laboratory dell'università di Nijmegen, questa volta a essere fatta levitare magneticamente è addirittura una rana!

Risalgono a pochi giorni fa due notizie che mostrano le prospettive dell'uso della levitazione magnetica rispettivamente nell'ingegneria tissutale (di cui abbiamo già parlato qui) e nella "fisiologia spaziale" (la scienza che studia le reazioni fisiologiche degli organismi viventi alle condizioni fisiche che si trovano nello spazio, come ad esempio la microgravità).

La prima notizia riguarda la messa a punto da parte della startup americana "n3D Biosciences" di un così detto "bioassemblatore magnetico". Questo dispositivo permette di crescere colture cellulari tridimensionali inserendo nanoparticelle all'interno delle cellule in coltura per poi farle levitare grazie a fenomeni magnetici. La possibilità crescere cellule in strutture 3D è fondamentale per l'ingegneria tissutale; questo nuovo sistema potrebbe offrire un alternativa rapida ed economica al così detto "bioprinting", la tecnica attualmente in uso in molti laboratori, nella quale successivi strati di cellule vengono depositati usando stampanti simili a quelle a getto d'inchiostro. La nuova tecnologia sviluppata dalla ditta americana offre grandi opportunità anche alla ricerca farmaceutica e biotecnologica. Le colture cellulari su substrati bidimensionali come le piastre di Petri, infatti, non riescono a replicare le complesse interazioni cellulari che si trovano negli organismi viventi, limitando la rilevanza fisiologica dei risultati delle ricerche. Il nuovo metodo di coltura potrebbe risolvere questo problema permettendo di ricreare un microambiente cellulare molto più simile a quello che si avrebbe in vivo. La tecnologia alla base del bioassemblatore era stata descritta, circa un anno fa, in un articolo sulla prestigiosa rivista "Nature nanotechnology".

La seconda notizia riguarda la pubblicazione di uno studio nel quale, fisici dell'università di Oxford, descrivono siano riusciti a simulare condizioni di "gravità artificiale" ( da 2g a quasi zero, cioè dal doppio della gravità terrestre alla microgravità di ambienti come la Stazione spaziale) sfruttando il fenomeno del diamagnetismo per studi di "fisiologia spaziale" . Nell'esperimento pubblicato sul "Journal of the Royal Society Interface", una rivista scientifica dedicata agli studi interdisciplinari al confine tra fisica e biologia, gli scienziati hanno fatto levitare dei moscerini della frutta grazie a un solenoide superconduttore in grado di generare un campo magnetico di 16 Tesla (che, a titolo di confronto è circa 5 volte più intenso di quello utilizzato nei più potenti scanner MR ospedalieri o 350000 volte più intenso del campo magnetico terrestre). Lo scopo dell’esperimento era quello di studiare le variazioni comportamentali legate alla microgravità, in particolare quelle relative al movimento. «Siamo così riusciti a dimostrare che i moscerini si comportano nel magnete esattamente come nello spazio: camminano più rapidamente», ha detto il primo autore dello studio, Richard Hill; «Perché ciò avvenga, ancora non lo sappiamo. È probabile che, a livello di muscoli e articolazioni, il movimento risulti facilitato dall’assenza di peso. Ma potrebbe anche essere un qualche tipo di risposta alla confusione che si crea, in assenza di gravità, fra dove sia "il sopra" e il "sotto"». «Studiandone gli effetti su organismi modello come il moscerino della frutta, possiamo sperare di ottenere informazioni circa gli effetti dell’assenza di peso su determinati meccanismi biologici. Senza contare che, pensando alle sfide che ci attendono nell’esplorazione dello spazio – la creazione di basi permanenti sulla Luna o su Marte, per esempio, o anche su altri pianeti – sarà fondamentale comprendere gli effetti dell’assenza di peso anche su altri organismi viventi: la nostra sopravvivenza a lungo termine richiederà, infatti, di portarne con noi molte specie differenti» ha concluso il ricercatore. Per ora non esiste un magnete superconduttore abbastanza potente da far levitare in quel modo un essere umano ma con il continuo miglioramento della tecnologia in questo campo chissà che un giorno non si arrivi anche a questo traguardo.

Il bizzarro video qui sotto mostra un esperimento eseguito di recente presso l'High Field Magnet Laboratory dell'università di Nijmegen, questa volta a essere fatta levitare magneticamente è addirittura una rana!

venerdì 13 gennaio 2012

ITFoM - Un "paziente virtuale" per rivoluzionare la medicina

Dopo aver discusso dello Human Brain Project nel post del primo dell'anno, oggi voglio parlarvi di un altro interessante progetto candidato a ricevere il miliardo di euro di stanziamento di ricerca del programma FET Flagships. Penso che sia il caso di far conoscere questi notevoli progetti anche perché, almeno qui in Italia, hanno una visibilità mediatica sorprendentemente, o forse dovrei dire tristemente, scarsa (eccezion fatta per FuturITC a cui è stato dedicato un interessante articolo sul numero di "Le Scienze" di questo mese).

Ma torniamo a noi, ciò di cui vi voglio parlare oggi è ITFoM, acronimo di "Information Technology Future of Medicine", che si potrebbe tradurre con "tecnologie dell'informazione per il futuro della medicina" (linko qui il bel sito ufficiale del progetto). L'obbiettivo di questo programma è quello di sfruttare il grande potenziale delle nuove tecnologie informatiche per rivoluzionare il settore sanitario. Già in un post di qualche tempo fa ("Il futuro della medicina - FutureMed") avevamo parlato di come lo sviluppo esponenziale di molte tecnologie, prime tra tutte quelle elettroniche e informatiche prometta di rivoluzionare la pratica clinica. Il punto centrale dell'ambizioso programma ITFoM è, però, addirittura, di: "integrare l'enorme numero di dati biologici a nostra disposizione per costruire un modello computazionale completo dei processi biologici che hanno luogo in ogni essere umano", per poter poi modificare di volta in volta questo vero e proprio "paziente virtuale" in modo da tenere conto delle peculiari caratteristiche anatomiche, fisiologiche e genetiche di ciascun paziente.

Chiaramente questa sorta di copia virtuale del corpo dei singoli pazienti potrebbe far fare un salto senza precedenti alla medicina, dando tutto un nuovo significato all'idea di medicina personalizzata (di cui si è già parlato qui). Come abbiamo già detto è ormai possibile analizzare moltissimi parametri rilevanti della biochimica, della fisiologia e della genetica di un paziente nel giro di poche ore. Questi dati integrati in un simile modello permetterebbero ai medici di sapere in anticipo l'effetto dei farmaci, conoscere rischi e predisposizioni a varie malattie, suggerire diete o cambi di stile di vita in modo del tutto personalizzato aumentando l'efficacia della prevenzione e dei trattamenti, riducendo al contempo gli effetti collaterali.

E' un consorzio di oltre 25 istituzioni accademiche europee a guidare questo sforzo per la creazione, entro dieci anni, di un "paziente virtuale". Il professor Hans Westerhoff dell'Università di Manchester ha affermato: "ITFoM realizzerà modelli computazionali generali di processi cellulari, tessuti, patologie e, alla fine, di un essere umano nella sua interezza. Rendere la medicina personalizzata una realtà tramite questo grande progetto è una grande sfida e richiederà sviluppi fondamentali nelle scienze computazionali. Questa, infatti è la prima volta che si cerca di realizzare un unico, enorme, sistema informatico pensato per combinare la genomica e la bioinformatica con le esigenze della pratica medica."

Gli sviluppi nell'area delle tecnologie informatiche di cui parla il professore comprendono nuove tecniche per l'acquisizione e la valutazione rapida di dati sui pazienti, nuovi modelli matematici dei sistemi biologici in cui integrare questi dati e nuovi software di intelligenza artificiale che possano apprendere e fare previsioni su queste basi per poi interfacciarsi con gli utenti.

Il professor Norman Paton, sempre dell'università di Manchester, ha aggiunto: "Le più grandi opportunità attuali per migliorare l'efficacia dei trattamenti medici vengono proprio dalla medicina personalizzata, le scienze biologiche oggi ci offrono la conoscenza adeguata per supportare una "personalizzazione informata" dei trattamenti, mentre le tecniche computazionali più avanzate sono essenziali per dare un senso ai dati alla base del processo decisionale. Questa è una fantastica opportunità per riunire gli sviluppi di queste aree scientifiche in rapida crescita e causare un cambiamento di paradigma nella pratica medica."

Ma torniamo a noi, ciò di cui vi voglio parlare oggi è ITFoM, acronimo di "Information Technology Future of Medicine", che si potrebbe tradurre con "tecnologie dell'informazione per il futuro della medicina" (linko qui il bel sito ufficiale del progetto). L'obbiettivo di questo programma è quello di sfruttare il grande potenziale delle nuove tecnologie informatiche per rivoluzionare il settore sanitario. Già in un post di qualche tempo fa ("Il futuro della medicina - FutureMed") avevamo parlato di come lo sviluppo esponenziale di molte tecnologie, prime tra tutte quelle elettroniche e informatiche prometta di rivoluzionare la pratica clinica. Il punto centrale dell'ambizioso programma ITFoM è, però, addirittura, di: "integrare l'enorme numero di dati biologici a nostra disposizione per costruire un modello computazionale completo dei processi biologici che hanno luogo in ogni essere umano", per poter poi modificare di volta in volta questo vero e proprio "paziente virtuale" in modo da tenere conto delle peculiari caratteristiche anatomiche, fisiologiche e genetiche di ciascun paziente.

Chiaramente questa sorta di copia virtuale del corpo dei singoli pazienti potrebbe far fare un salto senza precedenti alla medicina, dando tutto un nuovo significato all'idea di medicina personalizzata (di cui si è già parlato qui). Come abbiamo già detto è ormai possibile analizzare moltissimi parametri rilevanti della biochimica, della fisiologia e della genetica di un paziente nel giro di poche ore. Questi dati integrati in un simile modello permetterebbero ai medici di sapere in anticipo l'effetto dei farmaci, conoscere rischi e predisposizioni a varie malattie, suggerire diete o cambi di stile di vita in modo del tutto personalizzato aumentando l'efficacia della prevenzione e dei trattamenti, riducendo al contempo gli effetti collaterali.

E' un consorzio di oltre 25 istituzioni accademiche europee a guidare questo sforzo per la creazione, entro dieci anni, di un "paziente virtuale". Il professor Hans Westerhoff dell'Università di Manchester ha affermato: "ITFoM realizzerà modelli computazionali generali di processi cellulari, tessuti, patologie e, alla fine, di un essere umano nella sua interezza. Rendere la medicina personalizzata una realtà tramite questo grande progetto è una grande sfida e richiederà sviluppi fondamentali nelle scienze computazionali. Questa, infatti è la prima volta che si cerca di realizzare un unico, enorme, sistema informatico pensato per combinare la genomica e la bioinformatica con le esigenze della pratica medica."

Gli sviluppi nell'area delle tecnologie informatiche di cui parla il professore comprendono nuove tecniche per l'acquisizione e la valutazione rapida di dati sui pazienti, nuovi modelli matematici dei sistemi biologici in cui integrare questi dati e nuovi software di intelligenza artificiale che possano apprendere e fare previsioni su queste basi per poi interfacciarsi con gli utenti.

Il professor Norman Paton, sempre dell'università di Manchester, ha aggiunto: "Le più grandi opportunità attuali per migliorare l'efficacia dei trattamenti medici vengono proprio dalla medicina personalizzata, le scienze biologiche oggi ci offrono la conoscenza adeguata per supportare una "personalizzazione informata" dei trattamenti, mentre le tecniche computazionali più avanzate sono essenziali per dare un senso ai dati alla base del processo decisionale. Questa è una fantastica opportunità per riunire gli sviluppi di queste aree scientifiche in rapida crescita e causare un cambiamento di paradigma nella pratica medica."

giovedì 12 gennaio 2012

VLT - Il portabandiera dell'astronomia europea

In due post passati (qui e qui), abbiamo parlato dei telescopi ALMA e E-ELT che rappresentano il futuro dell'astronomia europea per il prossimo decennio. A questo punto non posso non dedicare un post anche a VLT, il telescopio che è, attualmente, lo strumento al centro dell'attività osservativa dell'ESO (European Southern Observatory). Questa struttura, il cui nome sta per "Very Large Telescope array" è, al momento il più avanzato telescopio ottico del mondo. VLT è costituito da quattro "unità-telescopio", ciascuna con uno specchio primario da 8.2 m di diametro, operanti insieme a otto telescopi ausiliari mobili con specchi da 1.8 m di diametro. Tutti questi telescopi, operando in maniera coordinata, si comportano come un gigantesco interferometro ottico che permette agli astronomi di vedere dettagli fino a 25 volte più fini di quelli che potrebbero essere osservati con i singoli telescopi. Per raggiungere questo risultato, i fasci di luce raccolti dai vari telescopi sono combinati usando un complesso sistema di specchi situato in tunnel sotterranei. La lunghezza del percorso dei raggi luminosi deve essere mantenuta su certi valori con precisioni dell'ordine del millesimo di millimetro perché la tecnica funzioni. Operando in questo modo il VLT può ricostruire immagini con una risoluzione angolare di pochi milliarcosecondi che equivale a distinguere un oggetto della dimensione di un pallone da calcio alla distanza della Luna. VLT, grazie alle sue caratteristiche uniche, ha catalizzato una nuova stagione di scoperte astronomiche e astrofisiche; tra i traguardi più notevoli raggiunti grazie a questo telescopio possiamo ricordare la prima immagine di un pianeta extrasolare (eso0428), l'individuazione del movimento delle singole stelle attorno al buco nero supermassiccio al centro della nostra galassia o l'osservazione del lampo di raggi gamma di origine più remota mai individuato.

Prima di lasciarvi alla visione del bel video di presentazione dell'VLT, una curiosità: la bellissima "Residencia Paranal" (il luogo che ospita gli astronomi durante i loro soggiorni osservativi al VLT) è stata utilizzata come set per le riprese del film "007 - Quantum of Solace".

Prima di lasciarvi alla visione del bel video di presentazione dell'VLT, una curiosità: la bellissima "Residencia Paranal" (il luogo che ospita gli astronomi durante i loro soggiorni osservativi al VLT) è stata utilizzata come set per le riprese del film "007 - Quantum of Solace".

lunedì 9 gennaio 2012

"Connectome" - Il nuovo libro di Sebastian Seung

Il 7 febbraio 2012 uscirà negli Stati Uniti: "Connectome. How the brain's wiring makes us who we are", saggio divulgativo scritto da Sebastian Seung. Del professor Seung, fisico e neuroscienziato all'MIT, e della connettomica abbiamo già parlato in due post precedenti (qui e qui), di cui consiglio la lettura per capire meglio ciò di cui stiamo parlando. Qui sotto vi propongo il poetico incipit del libro (da me liberamente tradotto in italiano):

"Né una strada, né un sentiero, penetrano in questa foresta. I rami lunghi e delicati dei suoi alberi si intrecciano ovunque, soffocando lo spazio con la loro crescita esuberante. Nessun raggio di sole può viaggiare lungo una traiettoria abbastanza tortuosa da attraversare gli angusti vuoti di questo groviglio di rami. Tutti gli alberi di questa buia foresta sono germogliati da cento miliardi di semi piantati contemporaneamente e, in un solo giorno, ognuno di essi è destinato a morire.

Questa maestosa foresta è comica e tragica allo stesso tempo. In effetti, certe volte penso che sia tutto. Qualunque romanzo o sinfonia, qualunque crudele omicidio o atto di pietà, qualunque storia d'amore o litigio, qualunque gioia o dolore, tutte, vengono dalla foresta.

Ci si potrebbe sorprendere nel sentire che tutto ciò stia in un contenitore di meno di trenta centimetri di diametro, o che ve ne siano sette miliardi sulla nostra Terra. Eppure tutti noi ci troviamo ad essere i custodi di una di queste foreste.

Gli alberi di cui sto parlando sono quelle particolari cellule chiamate neuroni.

La missione delle neuroscienze è quella di esplorare i loro rami incantati per domare la giungla della mente."

A questo indirizzo è già online il sito ufficiale del libro, in cui potrete trovare ulteriori informazioni (in inglese) e materiale, tra cui bellissimi video e immagini della "foresta cerebrale" di cui Seung parla nell'introduzione qui sopra. Per concludere in bellezza questo post voglio proprio mostrarvi uno di questi video che mostra il processo di ricostruzione 3D della struttura dei neuroni, una procedura che è al cuore della connettomica. Il volumetto di tessuto cerebrale che si vuole "mappare" viene sezionato da speciali macchine in sottilissimi foglietti che, dopo aver subito un complesso trattamento chimico di fissaggio, vengono scansionati tramite microscopi elettronici. Le sezioni così ottenute sono poi utilizzate da speciali software per effettuare una ricostruzione tomografica tridimensionale della forma di tutti i neuroni presenti nel campione di tessuto. Questo è possibile seguendo strato dopo strato, immagine dopo immagine, il lume dei rami dei neuroni che, nel video, potete riconoscere come macchie circolari di colore chiaro che punteggiano ogni singola sezione del volumetto.

Se qualcuno di voi fosse interessato, ecco il link della pagina di amazon su cui potete ordinare il libro.

PS: Consiglio anche la visione del bel video di presentazione del libro che linko qui.

Crosspostato su Estropico Blog.

"Né una strada, né un sentiero, penetrano in questa foresta. I rami lunghi e delicati dei suoi alberi si intrecciano ovunque, soffocando lo spazio con la loro crescita esuberante. Nessun raggio di sole può viaggiare lungo una traiettoria abbastanza tortuosa da attraversare gli angusti vuoti di questo groviglio di rami. Tutti gli alberi di questa buia foresta sono germogliati da cento miliardi di semi piantati contemporaneamente e, in un solo giorno, ognuno di essi è destinato a morire.

Questa maestosa foresta è comica e tragica allo stesso tempo. In effetti, certe volte penso che sia tutto. Qualunque romanzo o sinfonia, qualunque crudele omicidio o atto di pietà, qualunque storia d'amore o litigio, qualunque gioia o dolore, tutte, vengono dalla foresta.

Ci si potrebbe sorprendere nel sentire che tutto ciò stia in un contenitore di meno di trenta centimetri di diametro, o che ve ne siano sette miliardi sulla nostra Terra. Eppure tutti noi ci troviamo ad essere i custodi di una di queste foreste.

Gli alberi di cui sto parlando sono quelle particolari cellule chiamate neuroni.

La missione delle neuroscienze è quella di esplorare i loro rami incantati per domare la giungla della mente."

A questo indirizzo è già online il sito ufficiale del libro, in cui potrete trovare ulteriori informazioni (in inglese) e materiale, tra cui bellissimi video e immagini della "foresta cerebrale" di cui Seung parla nell'introduzione qui sopra. Per concludere in bellezza questo post voglio proprio mostrarvi uno di questi video che mostra il processo di ricostruzione 3D della struttura dei neuroni, una procedura che è al cuore della connettomica. Il volumetto di tessuto cerebrale che si vuole "mappare" viene sezionato da speciali macchine in sottilissimi foglietti che, dopo aver subito un complesso trattamento chimico di fissaggio, vengono scansionati tramite microscopi elettronici. Le sezioni così ottenute sono poi utilizzate da speciali software per effettuare una ricostruzione tomografica tridimensionale della forma di tutti i neuroni presenti nel campione di tessuto. Questo è possibile seguendo strato dopo strato, immagine dopo immagine, il lume dei rami dei neuroni che, nel video, potete riconoscere come macchie circolari di colore chiaro che punteggiano ogni singola sezione del volumetto.

Se qualcuno di voi fosse interessato, ecco il link della pagina di amazon su cui potete ordinare il libro.

PS: Consiglio anche la visione del bel video di presentazione del libro che linko qui.

Crosspostato su Estropico Blog.

domenica 8 gennaio 2012

Apologia del riduzionismo

In questo post voglio condividere con voi alcune mie riflessioni personali su riduzionismo, olismo e sistemi complessi.

Si sente spessissimo, negli ambienti culturali più diversi, criticare fortemente il riduzionismo (cioè la posizione epistemologica che vede le proprietà di qualunque sistema fisico come riconducibili a quelle dei suoi componenti elementari) che viene proposto come qualcosa di superato ed in qualche modo “riduttivo” in contrapposizione con l’olismo (la posizione filosofica basata sull'idea che le proprietà di un sistema non possano essere spiegate esclusivamente tramite le sue componenti). Prima di sparare a zero sul riduzionismo ricordiamoci, però, che il riduzionismo è sempre stato ed è tutt’oggi al cuore del metodo scientifico; se la scienza moderna è arrivata al livello di sviluppo attuale lo si deve a metodi d’indagine di tipo riduzionista che hanno pervaso i più diversi campi del sapere, a partire dalla fisica fino alla chimica ed alla biologia (basti pensare al fantastico sviluppo della biologia molecolare). Io penso che la contrapposizione tra olismo e riduzionismo, così come viene spesso presentata, sia fittizia. Quando si vogliono studiare scientificamente le proprietà di un sistema, ad una prima, necessaria, fase di analisi in cui si studiano le proprietà elementari del sistema, segue una fase di sintesi in cui le proprietà appena determinate sono utilizzate per spiegare alla loro luce le proprietà globali del sistema. Questo è vero anche nella più rigidamente riduzionista delle impostazioni di ricerca (riduzionismo non significa trascurare l'importanza dell'organizzazione dei sistemi!). E’ così che funziona l’indagine scientifica ed è questo che, generalmente, si intende come “spiegazione scientifica di un fenomeno”.

Prendendo da wikipedia, il nucleo centrale del pensiero olista è il concetto di comportamento emergente, così definito (tratto da P. Anderson, “More is different”, Science Vol. 177, No. 4047. 1972):

Il comportamento emergente di sistemi complessi … [ha luogo quando] … emergono proprietà inspiegabili sulla sola base delle leggi che governano le sue componenti, scaturenti da interazioni non-lineari tra le componenti stesse.

A mio parere però l’utilità operativa della parola “inspiegabile” è quantomeno scarsa nella ricerca e spesso apre la porta ad interpretazioni quasi “mistiche” del concetto di complessità che ben poco hanno di scientifico. Da questa definizione segue la seguente definizione di sistema complesso:

Un sistema complesso è un sistema che manifesta proprietà non prevedibili sulla base di quelle delle proprie parti (sic!).

Nessuno nega che sistemi abbastanza “complicati” possano manifestare comportamenti emergenti; di questi comportamenti parliamo spessissimo in questo blog e forse il più spettacolare è proprio quello che si manifesta come conseguenza della dinamica del complicatissimo sistema fisico che è racchiuso nella nostra scatola cranica, il cervello. Ciò che voglio contestare è invece la definizione “olista” di comportamento emergente, molto popolare, riportata sopra. Penso che una versione un pò più "riduzionista”, maggiormente “utile” e calzante di comportamento emergente e sistema complesso potrebbe essere:

Il comportamento emergente di sistemi complessi ha luogo quando emergono proprietà non semplicemente spiegabili sulla sola base delle leggi che governano le sue componenti, scaturenti da interazioni non-lineari tra le componenti stesse.

Da cui può seguire questa definizione di sistema complesso (tratta dall’articolo di Dominique Chu “Complexity: Against Systems” pubbicato nel 2011 su Theory in Biosciences; una rivista scientifica di biologia teorica):

Un sistema complesso è un sistema composto di parti interconnesse che manifesta proprietà non ovvie a partire dalle proprietà della sue parti individuali.

Questa definizione mi pare particolarmente buona in quanto sottolinea a dovere l'importanza delle interconnessioni tra le parti, e, quindi, dell'organzizzazione del sistema, pur non peccando di un eccessivo "anti-riduzionismo", come quella riportata più sopra (che sminuisce ingiustamente l'importanza delle proprietà delle parti costituenti). Va detto, inoltre, che due tra i principali strumenti teorici della così detta “scienza della complessità” sono la meccanica statistica (che affonda le sue radici nella termodinamica) e le simulazioni numeriche. Ciò che si fa applicando questi metodi è proprio risalire, a partire dalle proprietà elementari di un sistema, a quelle globali, emergenti, questo grazie alla conoscenza di come queste sono organzizzate ed interconnesse tra loro; a ben vedere questo è proprio un “trionfo” del riduzionismo, non certo il contrario.

Credo proprio che per il futuro della scienza non sia saggio ripudiare il riduzionismo, come sembra che alcuni, tra i quali anche diversi uomini di scienza, vogliano fare. In proposito voglio citare una frase (decisamente riduzionista! ;) ) di Leon Lederman, premio nobel per la fisica, che riporto liberamente dalle pagine del suo libro “The God Particle: If the Universe Is the Answer, What Is the Question?” (dal cui titolo è nato il soprannome “particella di Dio” per il bosone di Higgs):

"Se tutta la conoscenza scientifica fosse spazzata via in un attimo dalla faccia della Terra e dovessi scegliere un solo concetto scientifico da lasciare all’umanità per indirizzarla nella ricostruzione di una conoscenza del proprio mondo, questa sarebbe la teoria atomica; che l’universo al suo livello più fondamentale è costituito da atomi, unità elementari che interagendo in base a poche, semplici regole, danno origine a qualunque fenomeno possiamo osservare. Da questo concetto sarebbe possibile ricostruire tutto quel maestoso “edificio intellettuale” che è la scienza moderna."

(Nell’immagine in alto a sinistra è riportata una stampa della “Papera di Vaucanson”; un simbolo del riduzionismo meccanicista che animava l’illuminismo settecentesco che, nell'ambito delle scienze biologiche, si opponeva al vitalismo di stampo idealista).

Si sente spessissimo, negli ambienti culturali più diversi, criticare fortemente il riduzionismo (cioè la posizione epistemologica che vede le proprietà di qualunque sistema fisico come riconducibili a quelle dei suoi componenti elementari) che viene proposto come qualcosa di superato ed in qualche modo “riduttivo” in contrapposizione con l’olismo (la posizione filosofica basata sull'idea che le proprietà di un sistema non possano essere spiegate esclusivamente tramite le sue componenti). Prima di sparare a zero sul riduzionismo ricordiamoci, però, che il riduzionismo è sempre stato ed è tutt’oggi al cuore del metodo scientifico; se la scienza moderna è arrivata al livello di sviluppo attuale lo si deve a metodi d’indagine di tipo riduzionista che hanno pervaso i più diversi campi del sapere, a partire dalla fisica fino alla chimica ed alla biologia (basti pensare al fantastico sviluppo della biologia molecolare). Io penso che la contrapposizione tra olismo e riduzionismo, così come viene spesso presentata, sia fittizia. Quando si vogliono studiare scientificamente le proprietà di un sistema, ad una prima, necessaria, fase di analisi in cui si studiano le proprietà elementari del sistema, segue una fase di sintesi in cui le proprietà appena determinate sono utilizzate per spiegare alla loro luce le proprietà globali del sistema. Questo è vero anche nella più rigidamente riduzionista delle impostazioni di ricerca (riduzionismo non significa trascurare l'importanza dell'organizzazione dei sistemi!). E’ così che funziona l’indagine scientifica ed è questo che, generalmente, si intende come “spiegazione scientifica di un fenomeno”.

Prendendo da wikipedia, il nucleo centrale del pensiero olista è il concetto di comportamento emergente, così definito (tratto da P. Anderson, “More is different”, Science Vol. 177, No. 4047. 1972):

Il comportamento emergente di sistemi complessi … [ha luogo quando] … emergono proprietà inspiegabili sulla sola base delle leggi che governano le sue componenti, scaturenti da interazioni non-lineari tra le componenti stesse.

A mio parere però l’utilità operativa della parola “inspiegabile” è quantomeno scarsa nella ricerca e spesso apre la porta ad interpretazioni quasi “mistiche” del concetto di complessità che ben poco hanno di scientifico. Da questa definizione segue la seguente definizione di sistema complesso:

Un sistema complesso è un sistema che manifesta proprietà non prevedibili sulla base di quelle delle proprie parti (sic!).

Nessuno nega che sistemi abbastanza “complicati” possano manifestare comportamenti emergenti; di questi comportamenti parliamo spessissimo in questo blog e forse il più spettacolare è proprio quello che si manifesta come conseguenza della dinamica del complicatissimo sistema fisico che è racchiuso nella nostra scatola cranica, il cervello. Ciò che voglio contestare è invece la definizione “olista” di comportamento emergente, molto popolare, riportata sopra. Penso che una versione un pò più "riduzionista”, maggiormente “utile” e calzante di comportamento emergente e sistema complesso potrebbe essere:

Il comportamento emergente di sistemi complessi ha luogo quando emergono proprietà non semplicemente spiegabili sulla sola base delle leggi che governano le sue componenti, scaturenti da interazioni non-lineari tra le componenti stesse.

Da cui può seguire questa definizione di sistema complesso (tratta dall’articolo di Dominique Chu “Complexity: Against Systems” pubbicato nel 2011 su Theory in Biosciences; una rivista scientifica di biologia teorica):

Un sistema complesso è un sistema composto di parti interconnesse che manifesta proprietà non ovvie a partire dalle proprietà della sue parti individuali.

Questa definizione mi pare particolarmente buona in quanto sottolinea a dovere l'importanza delle interconnessioni tra le parti, e, quindi, dell'organzizzazione del sistema, pur non peccando di un eccessivo "anti-riduzionismo", come quella riportata più sopra (che sminuisce ingiustamente l'importanza delle proprietà delle parti costituenti). Va detto, inoltre, che due tra i principali strumenti teorici della così detta “scienza della complessità” sono la meccanica statistica (che affonda le sue radici nella termodinamica) e le simulazioni numeriche. Ciò che si fa applicando questi metodi è proprio risalire, a partire dalle proprietà elementari di un sistema, a quelle globali, emergenti, questo grazie alla conoscenza di come queste sono organzizzate ed interconnesse tra loro; a ben vedere questo è proprio un “trionfo” del riduzionismo, non certo il contrario.

Credo proprio che per il futuro della scienza non sia saggio ripudiare il riduzionismo, come sembra che alcuni, tra i quali anche diversi uomini di scienza, vogliano fare. In proposito voglio citare una frase (decisamente riduzionista! ;) ) di Leon Lederman, premio nobel per la fisica, che riporto liberamente dalle pagine del suo libro “The God Particle: If the Universe Is the Answer, What Is the Question?” (dal cui titolo è nato il soprannome “particella di Dio” per il bosone di Higgs):

"Se tutta la conoscenza scientifica fosse spazzata via in un attimo dalla faccia della Terra e dovessi scegliere un solo concetto scientifico da lasciare all’umanità per indirizzarla nella ricostruzione di una conoscenza del proprio mondo, questa sarebbe la teoria atomica; che l’universo al suo livello più fondamentale è costituito da atomi, unità elementari che interagendo in base a poche, semplici regole, danno origine a qualunque fenomeno possiamo osservare. Da questo concetto sarebbe possibile ricostruire tutto quel maestoso “edificio intellettuale” che è la scienza moderna."

(Nell’immagine in alto a sinistra è riportata una stampa della “Papera di Vaucanson”; un simbolo del riduzionismo meccanicista che animava l’illuminismo settecentesco che, nell'ambito delle scienze biologiche, si opponeva al vitalismo di stampo idealista).

sabato 7 gennaio 2012

La nanotecnologia si fa grande

In una piccola cittadina del New Hampshire, Concord, i ricercatori di una piccola startup nanotecnologica, la Nanocomp, sono riusciti a mettere a punto un nuovo metodo per produrre sottili fogli di nanotubi di carbonio lunghi vari metri.

I nanotubi di carbonio, sottilissimi cilindri di pochi nanometri di diametro, formati da un singolo strato di atomi, sono tra i materiali con la più alta resistenza meccanica e conducibilità elettrica noti.

Le proprietà uniche di questo materiale permetterebbero di utilizzarlo per realizzare linee di trasmissione energetica super efficienti (con un enorme risparmio di energia elettrica), ponti sospesi lunghi chilometri, veicoli super leggeri a risparmio energetico e perfino i così detti "ascensori spaziali" (dispositivi simili ad ascensori che servirebbe a portare carichi in orbita ad un costo minimo rispetto a quello attuale).

L'ostacolo al pieno sfruttamento delle potenzialità tecnologiche dei nanotubi è sempre stato la difficoltà di di produrli su vasta scala e a costi contenuti "tessendoli" a formare dei materiali che conservino le loro uniche caratteristiche elettriche e meccaniche.

Alcune compagnie nanotecnologiche hanno già realizzato con successo dei prodotti utili miscelando i nanotubi con resine per creare materiali compositi, questi, però, perdono, almeno in parte, le straordinarie proprietà dei loro componenti individuali. Questo problema sembra essere stato, almeno parzialmente, risolto dai ricercatori della Nanocomp. Nel nuovo processo di produzione da loro messo a punto dell'alcool viene posto a contatto con un particolare catalizzatore all'interno di una fornace ad alte temperature e pressioni. Un attento lavoro di regolazione del processo permette di produrre nanotubi relativamente lunghi, incrociati a formare un reticolo tale da permettere la realizzazione di grandi fogli che conservano, in buona misura, le caratteristiche originali di resistenza e conducibilità dei singoli nanotubi. La tecnica messa a punto dalla Nanocomp per produrre fogli di nanotubi puri fa compiere un grande passo in avanti nella direzione dello sfruttamento alla macroscala delle eccezionali proprietà dei nanotubi e apre la possibilità di mettere sul mercato nuovi prodotti a prezzi competitivi.

I nanotubi di carbonio, sottilissimi cilindri di pochi nanometri di diametro, formati da un singolo strato di atomi, sono tra i materiali con la più alta resistenza meccanica e conducibilità elettrica noti.

Le proprietà uniche di questo materiale permetterebbero di utilizzarlo per realizzare linee di trasmissione energetica super efficienti (con un enorme risparmio di energia elettrica), ponti sospesi lunghi chilometri, veicoli super leggeri a risparmio energetico e perfino i così detti "ascensori spaziali" (dispositivi simili ad ascensori che servirebbe a portare carichi in orbita ad un costo minimo rispetto a quello attuale).

L'ostacolo al pieno sfruttamento delle potenzialità tecnologiche dei nanotubi è sempre stato la difficoltà di di produrli su vasta scala e a costi contenuti "tessendoli" a formare dei materiali che conservino le loro uniche caratteristiche elettriche e meccaniche.

Alcune compagnie nanotecnologiche hanno già realizzato con successo dei prodotti utili miscelando i nanotubi con resine per creare materiali compositi, questi, però, perdono, almeno in parte, le straordinarie proprietà dei loro componenti individuali. Questo problema sembra essere stato, almeno parzialmente, risolto dai ricercatori della Nanocomp. Nel nuovo processo di produzione da loro messo a punto dell'alcool viene posto a contatto con un particolare catalizzatore all'interno di una fornace ad alte temperature e pressioni. Un attento lavoro di regolazione del processo permette di produrre nanotubi relativamente lunghi, incrociati a formare un reticolo tale da permettere la realizzazione di grandi fogli che conservano, in buona misura, le caratteristiche originali di resistenza e conducibilità dei singoli nanotubi. La tecnica messa a punto dalla Nanocomp per produrre fogli di nanotubi puri fa compiere un grande passo in avanti nella direzione dello sfruttamento alla macroscala delle eccezionali proprietà dei nanotubi e apre la possibilità di mettere sul mercato nuovi prodotti a prezzi competitivi.

venerdì 6 gennaio 2012

Tirotropina e globuli rossi

In questo post voglio mostrarvi l'ultima fatica del team di visualizzazione scientifica dell'IFC (Istituto di Fisiologia Clinica), di cui abbiamo già parlato in uno dei primi post. Questo breve filmato è stato prodotto per illustrare alcune nuove scoperte dei ricercatori dell'IFC riguardo la presenza di recettori della tirotropina (anche detta "ormone tireostimolante") sui globuli rossi (qui lo studio). La tirotropina è un ormone secreto dall'ipofisi la cui principale funzione è di controllare l'attività secretiva della ghiandola tiroide.

Il video è accompagnato dalla musica di Nicola Piovani (vincitore di un premio Oscar) e dalla voce dell'attore Ugo Morosi che illustra ciò che viene mostrato nelle immagini. L'animazione, che fa dell'accuratezza scientifica il suo punto di forza, è stata realizzata usando il software "BioBlender", un programma di grafica e animazione 3D appositamente creato dai ricercatori dell'IFC. I dati su cui si è basato il gruppo sono quelli del "Protein Data Bank"; un archivio per dati strutturali 3D di proteine e acidi nucleici, ottenuti soprattutto grazie alla cristallografia a raggi X o alla spettrografia NMR.

Con i suoi video, il gruppo di ricercatori del CNR è presente su "Molecular Movies.org", un bel portale che raccoglie animazioni cellulari e molecolari realizzate da ricercatori di tutto il mondo; consiglio una visita a tutti coloro che avessero voglia di vedere altri cortometraggi di questo tipo. Per chi fosse interessato, a questo indirizzo, è disponibile una spiegazione tecnica sul contenuto e sulle tecniche di realizzazione del video qui sotto. Buona visione!

Il video è accompagnato dalla musica di Nicola Piovani (vincitore di un premio Oscar) e dalla voce dell'attore Ugo Morosi che illustra ciò che viene mostrato nelle immagini. L'animazione, che fa dell'accuratezza scientifica il suo punto di forza, è stata realizzata usando il software "BioBlender", un programma di grafica e animazione 3D appositamente creato dai ricercatori dell'IFC. I dati su cui si è basato il gruppo sono quelli del "Protein Data Bank"; un archivio per dati strutturali 3D di proteine e acidi nucleici, ottenuti soprattutto grazie alla cristallografia a raggi X o alla spettrografia NMR.

Con i suoi video, il gruppo di ricercatori del CNR è presente su "Molecular Movies.org", un bel portale che raccoglie animazioni cellulari e molecolari realizzate da ricercatori di tutto il mondo; consiglio una visita a tutti coloro che avessero voglia di vedere altri cortometraggi di questo tipo. Per chi fosse interessato, a questo indirizzo, è disponibile una spiegazione tecnica sul contenuto e sulle tecniche di realizzazione del video qui sotto. Buona visione!

martedì 3 gennaio 2012

L'occhio bionico

In questo video TEDMED, Sheila Nirenberg ci mostra il frutto del suo lavoro di ricerca: una protesi retinica che, connettendosi con il nervo ottico, è in grado di inviare direttamente al cervello i segnali di una videocamera dopo averli correttamente codificati, ed in pratica "tradotti", in modo da essere "comprensibili" per il cervello. Il dispositivo della Nirenberg, testato con successo sui topi, promette di ridare la vista a persone affette da vari tipi di cecità come, ad esempio quella causata dalla retinite pigmentosa.

Sheila Nirenberg è professoressa di fisiologia e biofisica presso il Weill Medical College della Cornell University, i suoi studi si concentrano sul "neural coding", cioè su come il cervello codifichi le informazioni provenienti dai sensi in schemi di attività elettrica neuronale. L'obbiettivo è quello di riuscire a decodificare l'attività neurale in modo da essere in grado di capire da questa, che cosa un animale stia vedendo, provando o pensando in un determinato momento.

Proprio la corretta codifica dei segnali da inviare al cervello è stata, negli ultimi anni, l'ostacolo che ha impedito la realizzazione di protesi retiniche efficaci. Per questo motivo la professoressa Nirenberg si è dedicata ad applicare i risultati delle sue precedenti ricerche riguardanti la codifica neurale allo sviluppo di protesi innovative.

Il cuore del dispositivo realizzato dal gruppo della Nirenberg è costituito da due parti, un codificatore ed un trasduttore che possono bypassare una retina danneggiata. Il primo codifica l'informazione visiva in un messaggio simile a quello che verrebbe generato da una retina biologica, sfruttando modelli computazionali delle reti di neuroni della retina stessa. Il secondo trasmette questo segnale alle cellule gangliari (i cui assoni sono riuniti a formare il nervo ottico) del soggetto che sono in grado di interpretarlo come se si trattasse di un segnale "naturale" e trasmetterlo al cervello tramite il nervo ottico.

Le possibilità mediche aperte da questa tecnologia sono enormi; trovare il modo di comunicare con il cervello nel suo stesso "linguaggio" potrebbe portare a nuovi trattamenti, ad esempio, per la sordità o per vari tipi di disordini motori.

Le future applicazioni di una simile tecnologia però non si limitano all'ambito sanitario. La possibilità di sostituire gli imput provenienti dei sensi al cervello con segnali "artificiali" sarebbe un passo da gigante per lo sviluppo di tecnologie di realtà virtuale o di realtà aumentata a cui ci ha abituato la fantascienza con film come "Matrix". La professoressa Nirenberg ha affermato: "Comprendere il codice del cervello è davvero importante; nel momento in cui comprenderemo a pieno il linguaggio del cervello diverranno possibili cose prima non ritenute tali".

Per quanto riguarda i tempi, quando viene chiesto alla Nirenberg se bisognerà aspettare dieci anni per vedere diventare la sua tecnologia di uso comune sull'uomo lei risponde, "no, spero meno".

Sheila Nirenberg è professoressa di fisiologia e biofisica presso il Weill Medical College della Cornell University, i suoi studi si concentrano sul "neural coding", cioè su come il cervello codifichi le informazioni provenienti dai sensi in schemi di attività elettrica neuronale. L'obbiettivo è quello di riuscire a decodificare l'attività neurale in modo da essere in grado di capire da questa, che cosa un animale stia vedendo, provando o pensando in un determinato momento.

Proprio la corretta codifica dei segnali da inviare al cervello è stata, negli ultimi anni, l'ostacolo che ha impedito la realizzazione di protesi retiniche efficaci. Per questo motivo la professoressa Nirenberg si è dedicata ad applicare i risultati delle sue precedenti ricerche riguardanti la codifica neurale allo sviluppo di protesi innovative.

Il cuore del dispositivo realizzato dal gruppo della Nirenberg è costituito da due parti, un codificatore ed un trasduttore che possono bypassare una retina danneggiata. Il primo codifica l'informazione visiva in un messaggio simile a quello che verrebbe generato da una retina biologica, sfruttando modelli computazionali delle reti di neuroni della retina stessa. Il secondo trasmette questo segnale alle cellule gangliari (i cui assoni sono riuniti a formare il nervo ottico) del soggetto che sono in grado di interpretarlo come se si trattasse di un segnale "naturale" e trasmetterlo al cervello tramite il nervo ottico.

Le possibilità mediche aperte da questa tecnologia sono enormi; trovare il modo di comunicare con il cervello nel suo stesso "linguaggio" potrebbe portare a nuovi trattamenti, ad esempio, per la sordità o per vari tipi di disordini motori.

Le future applicazioni di una simile tecnologia però non si limitano all'ambito sanitario. La possibilità di sostituire gli imput provenienti dei sensi al cervello con segnali "artificiali" sarebbe un passo da gigante per lo sviluppo di tecnologie di realtà virtuale o di realtà aumentata a cui ci ha abituato la fantascienza con film come "Matrix". La professoressa Nirenberg ha affermato: "Comprendere il codice del cervello è davvero importante; nel momento in cui comprenderemo a pieno il linguaggio del cervello diverranno possibili cose prima non ritenute tali".

Per quanto riguarda i tempi, quando viene chiesto alla Nirenberg se bisognerà aspettare dieci anni per vedere diventare la sua tecnologia di uso comune sull'uomo lei risponde, "no, spero meno".

domenica 1 gennaio 2012

2012 - L'anno dello Human Brain Project?

L'anno appena iniziato sarà probabilmente un anno importante per il Blue Brain Project. Questo progetto di ricerca dovrebbe portare, entro il 2023, alla realizzazione di una simulazione su supercomputer che, come ha affermato il suo stesso direttore, Henry Markram: "riprodurrà integralmente un cervello umano, emozioni comprese” (di tutto questo abbiamo già parlato più nel dettaglio qui). Come dicevo, questo potrebbe essere un anno di svolta, il progetto, infatti, è candidato per ricevere un grosso finanziamento di ricerca dell'unione europea nell'ambito del programma Future and Emerging Technologies (FET) Flagships Initiative. I finanziamenti ammonterebbero a circa un miliardo di euro in dieci anni e permetterebbero un’accelerazione sostanziale con il raggiungimento degli obiettivi in tempi più rapidi; la decisione finale riguardo all'assegnazione dei fondi è attesa per la metà di quest'anno. In caso di vittoria nel concorso il progetto Blue Brain verrebbe rinominato Human Brain Project, e da svizzero diventerebbe a tutti gli effetti un progetto europeo, coinvolgendo istituzioni scientifiche di tutto il continente.

Anche l'Italia potrebbe ritagliarsi un ruolo in tutto questo, con sei ricercatori nel gruppo di oltre 150 scienziati che stanno lavorando alla predisposizione della proposta di finanziamento per il progetto HBP. I rispettivi enti di appartenenza (Politecnico di Torino, Università di Pavia, Università di Firenze, LENS e CNR con gli istituti di Scienze e Tecnologie della Cognizione (Roma), di Biofisica (Palermo) e di Ricerche sulla Popolazione e le Politiche Sociali (Roma) hanno dato vita ad un “cluster” nazionale che si propone di ricoprire un ruolo di primo piano nella predisposizione e, successivamente, nell’esecuzione del progetto. Ecco alcune delle dichiarazioni degli scienziati italiani che hanno partecipato, quest'anno, a Torino, alla prima conferenza della collaborazione:

“Il LENS e l’università di Firenze si occuperanno della messa a punto di un tomografo ottico per la ricostruzione dell’intera rete del cervello con un dettaglio mille volte superiore alle tecniche esistenti, tipo la Risonanza magnetica Nucleare. Uno degli scopi principali della ricerca fiorentina verterà sul collegamento struttura-funzione della rete neurale. In altre parole, proveremo a capire in che maniera patologie come l’autismo o la schizofrenia sono legate ad una particolare struttura di rete neurale, o come, ad esempio, le caratteristiche dell’apprendimento sono legate a particolari soluzioni di rete che il cervello adotta”. Ha affermato Francesco Pavone dell'Università di Firenze.

“Il gruppo di ricerca dell’Università di Pavia in associazione con l’IRCCS Istituto Neurologico Nazionale C. Mondino, porterà alla generazione del primo modello computazionale realistico del cervelletto. Tale componente fondamentale verrà integrata nel modello del cervello dello Human Brain Project. Le simulazioni saranno supportate da ricerche sperimentali, cellulari ed applicate”, ha dichiarato Egidio D’Angelo, dell’Università di Pavia.

Michele Migliore, referente del progetto per l’IBF del CNR, ha spiegato: “il laboratorio di Neuroscienze Computazionali dell' Istituto di Biofisica (Palermo) metterà a disposizione dello HBP le proprie competenze di Multiscale modeling di neuroni e reti di neuroni realistiche, Simulazioni di sinapsi e meccanismi di plasticità sinaptica, Modelli di simulazione di disfunzioni e patologie del sistema nervoso centrale”.

Orazio Miglino, dell’ISTC del CNR ha commentato: "Henry Markram propone una sfida che, come spesso è accaduto nell'avvio delle grandi avventure umane, è stata anticipata dalla fantascienza e dalla fantasia letteraria. In "2001 Odissea nello spazio" Stanley Kubrick illustra l'evoluzione del cammino umano nell'esplorazione dell'Universo facendola concludere con l'ultimo e più intimo luogo della sua esistenza: il cervello di un feto umano. Markram, novello Ulisse, sta raccogliendo intorno a se una ciurma di ricercatori pronti ad esplorare (e riprodurre) questo luogo. Sarà l'Impresa del XXI secolo”.

“L'Istituto di Ricerca sulla Popolazione e le Politiche Sociali del CNR è molto attento alla ricerca scientifica e alle tecnologie che hanno impatto sulla società e sulle persone. E' in questa direzione che si colloca l'adesione allo Human Brain Project, iniziativa che affronterà almeno tre grandi sfide scientifiche rivolte a migliorare la vita delle persone: comprendere il cervello umano e le malattie neurologiche, definire nuove macchine computazionali più simili al cervello umano e definire nuovi modelli computazionali in grado di riconoscere e processare la complessità della realtà che è intorno a noi. Al termine del progetto le conoscenze sviluppate permetteranno, tra i vari risultati, di individuare cure per le malattie neurologiche e di realizzare macchine con le quali è possibile interagire e comunicare in modo naturale”, ha concluso Fernando Ferri, dell’IRPPS del CNR.

Voglio concludere questo primo post dell'anno proponendovi una bella conferenza TED, registrata nel 2009, in cui Henry Markram illustra le sfide e le finalità del progetto Blue Brain. Per chi fosse interessato, a questi indirizzi (qui e qui) sono invece disponibili i primi due video-documentari (in inglese) di una serie che dovrebbe seguire, anno per anno, le tappe del progetto.

A questo punto non mi resta che augurarvi buona visione e buon anno nuovo!

PS: Aggiungo qui il link a un dettagliato e interessante report sulle attività dello HBP realizzato nell'aprile 2012 per la commissione europea...

Anche l'Italia potrebbe ritagliarsi un ruolo in tutto questo, con sei ricercatori nel gruppo di oltre 150 scienziati che stanno lavorando alla predisposizione della proposta di finanziamento per il progetto HBP. I rispettivi enti di appartenenza (Politecnico di Torino, Università di Pavia, Università di Firenze, LENS e CNR con gli istituti di Scienze e Tecnologie della Cognizione (Roma), di Biofisica (Palermo) e di Ricerche sulla Popolazione e le Politiche Sociali (Roma) hanno dato vita ad un “cluster” nazionale che si propone di ricoprire un ruolo di primo piano nella predisposizione e, successivamente, nell’esecuzione del progetto. Ecco alcune delle dichiarazioni degli scienziati italiani che hanno partecipato, quest'anno, a Torino, alla prima conferenza della collaborazione:

“Il LENS e l’università di Firenze si occuperanno della messa a punto di un tomografo ottico per la ricostruzione dell’intera rete del cervello con un dettaglio mille volte superiore alle tecniche esistenti, tipo la Risonanza magnetica Nucleare. Uno degli scopi principali della ricerca fiorentina verterà sul collegamento struttura-funzione della rete neurale. In altre parole, proveremo a capire in che maniera patologie come l’autismo o la schizofrenia sono legate ad una particolare struttura di rete neurale, o come, ad esempio, le caratteristiche dell’apprendimento sono legate a particolari soluzioni di rete che il cervello adotta”. Ha affermato Francesco Pavone dell'Università di Firenze.

“Il gruppo di ricerca dell’Università di Pavia in associazione con l’IRCCS Istituto Neurologico Nazionale C. Mondino, porterà alla generazione del primo modello computazionale realistico del cervelletto. Tale componente fondamentale verrà integrata nel modello del cervello dello Human Brain Project. Le simulazioni saranno supportate da ricerche sperimentali, cellulari ed applicate”, ha dichiarato Egidio D’Angelo, dell’Università di Pavia.

Michele Migliore, referente del progetto per l’IBF del CNR, ha spiegato: “il laboratorio di Neuroscienze Computazionali dell' Istituto di Biofisica (Palermo) metterà a disposizione dello HBP le proprie competenze di Multiscale modeling di neuroni e reti di neuroni realistiche, Simulazioni di sinapsi e meccanismi di plasticità sinaptica, Modelli di simulazione di disfunzioni e patologie del sistema nervoso centrale”.